AccuRIGの自動リギングが良さそうだったので、Blenderと組み合わせてアニメーションつけてみました。その手順です。

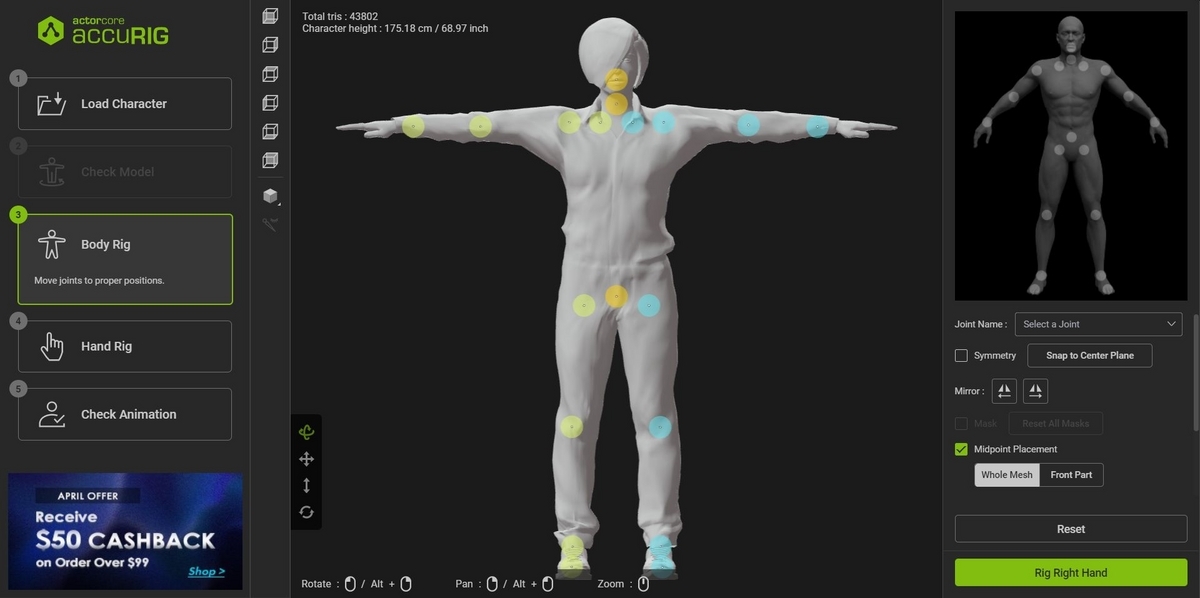

人型のFBXをAccuRIGにインポートすると、自動でBodyRigを設定してくれます。(キャラクターなど厳密には人型でない場合は、自動でBodyRigを設定してもらった後、不要なRigをMaskします)

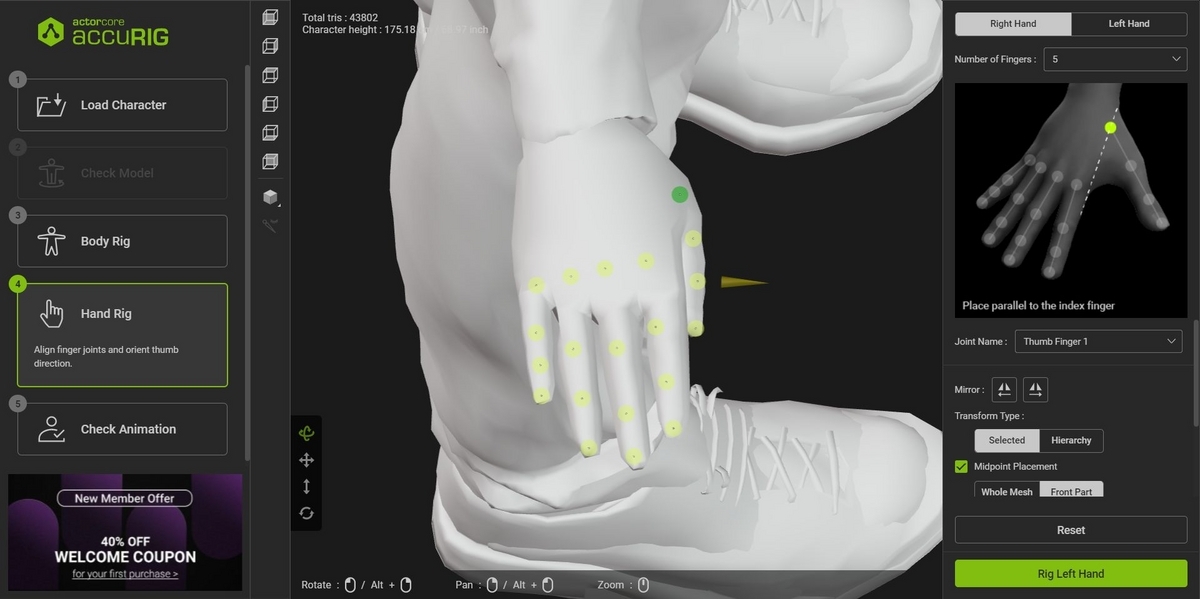

HandRigも自動で設定してくれます。気になるところがあれば微調整します。

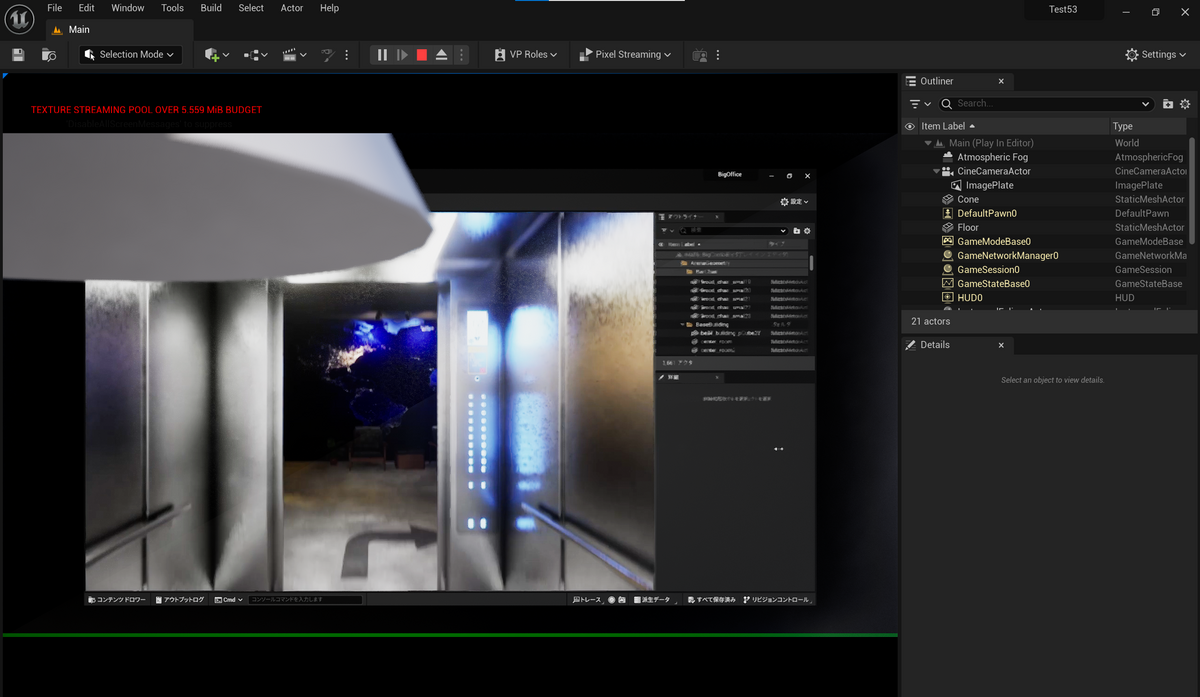

リグが組めた状態になるので、「Upload to Actor core」ボタンをおして、AccuRIGが提供しているクラウドサービスにUploadします。(デフォルトは非公開設定)合わせて、Exportボタンも押して、リグありモデルをBlender用としてFBX保存しておきます。

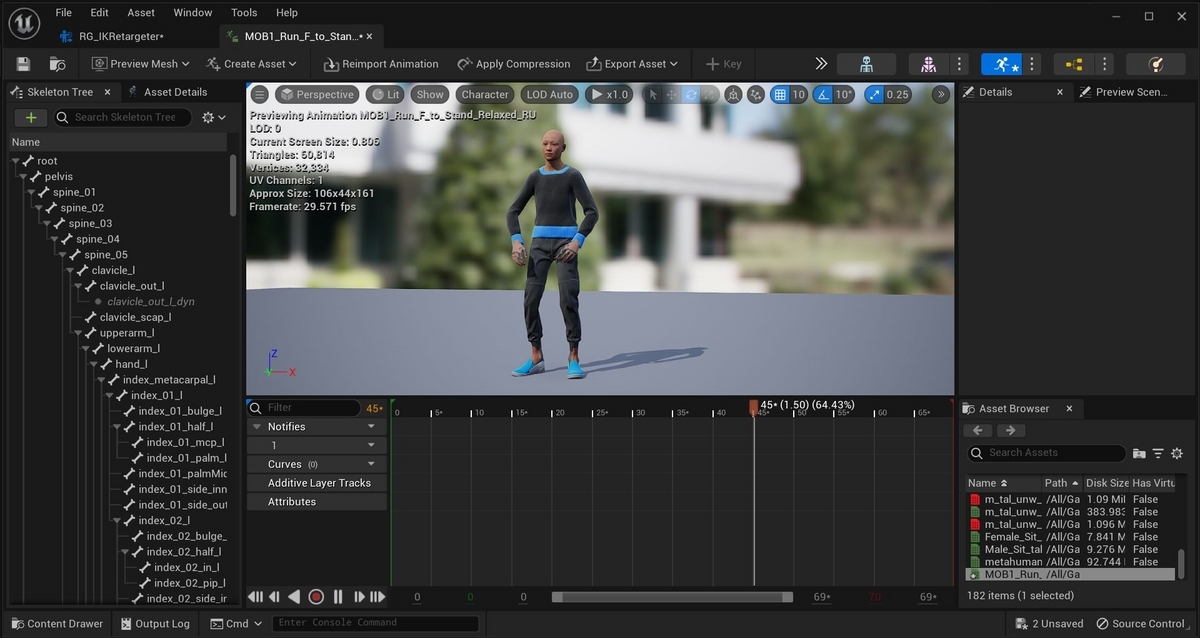

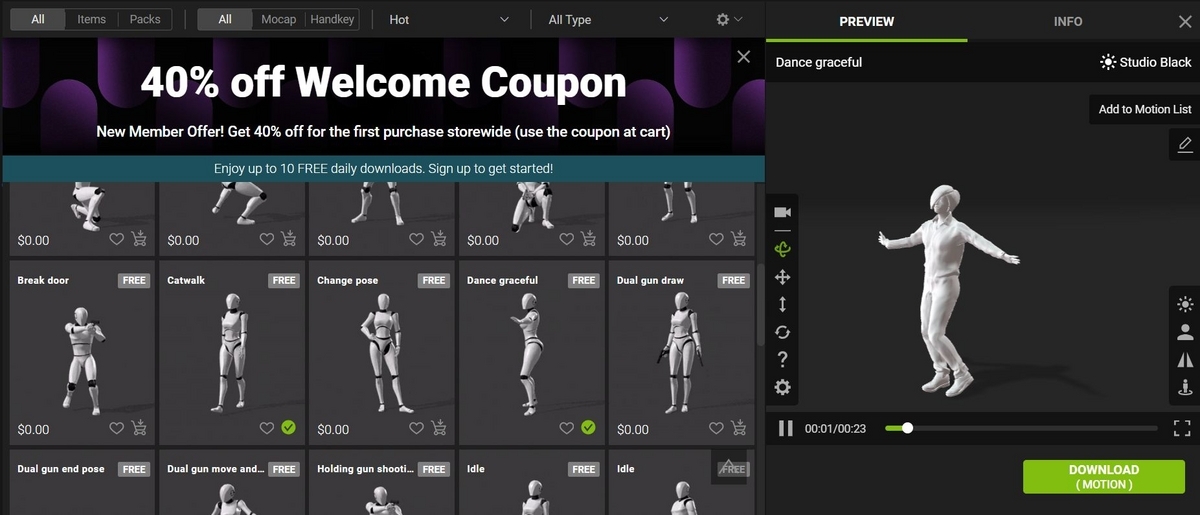

AccuRIGが提供しているクラウドサービスで無料のアニメーションをカートに入れて購入、先ほどUploadしたモデルに適応します。

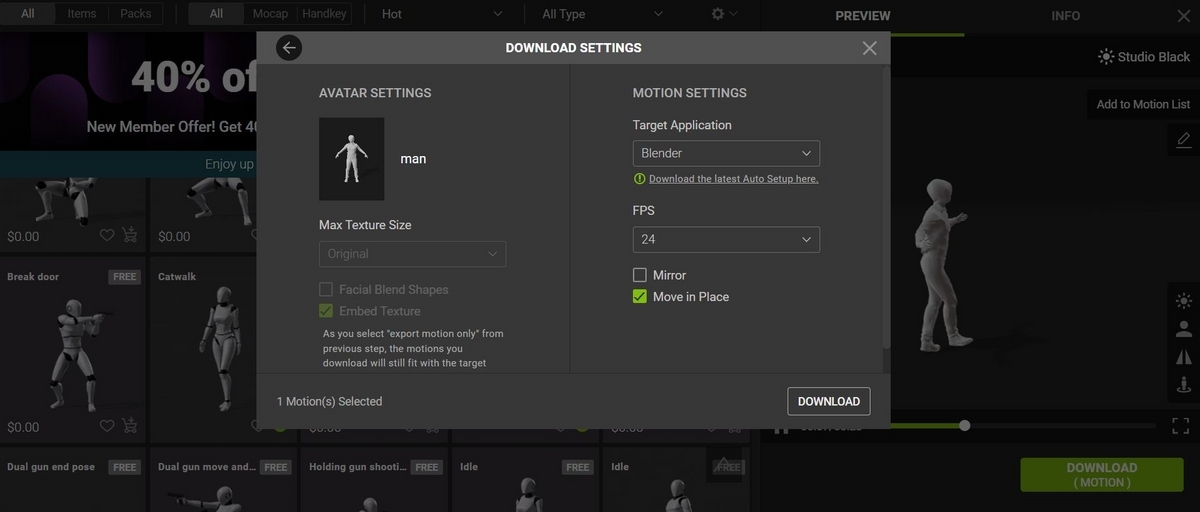

Download(Motion)ボタンを押すと、使うプラットフォーム(今回はBlender)等を指定してFBXでアニメーションをダウンロードできます。

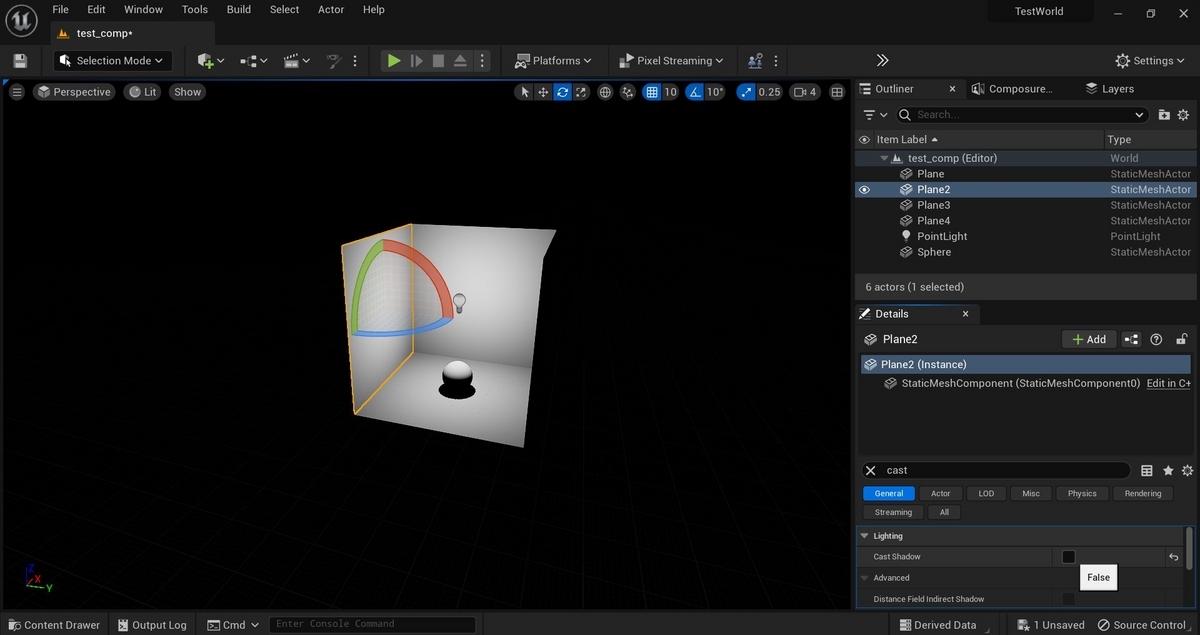

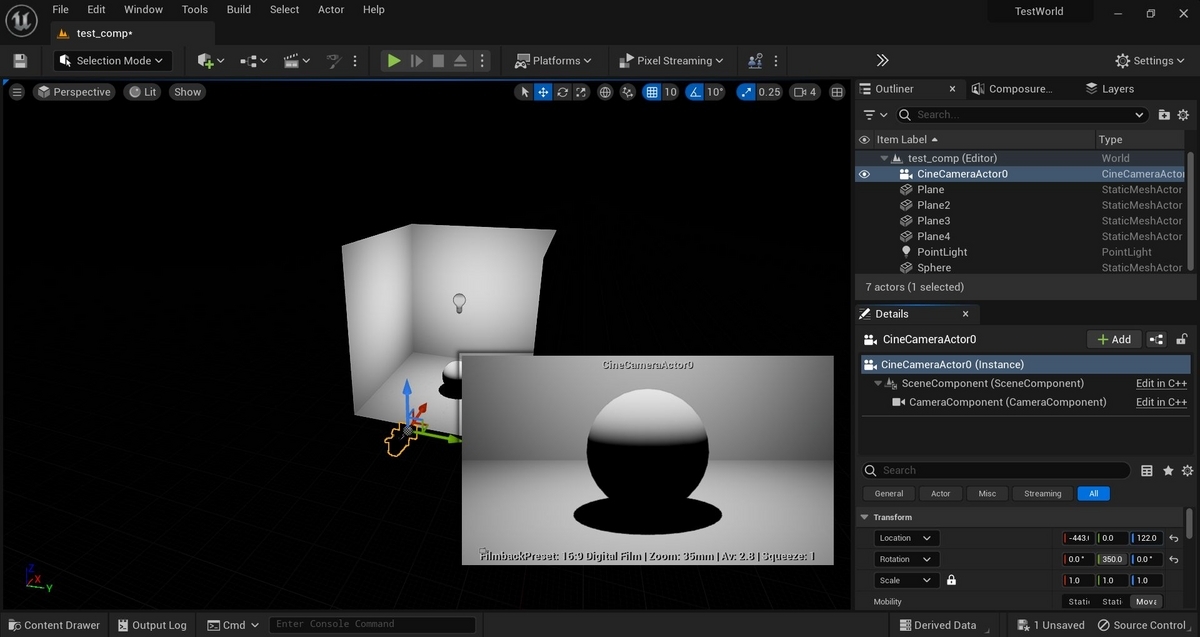

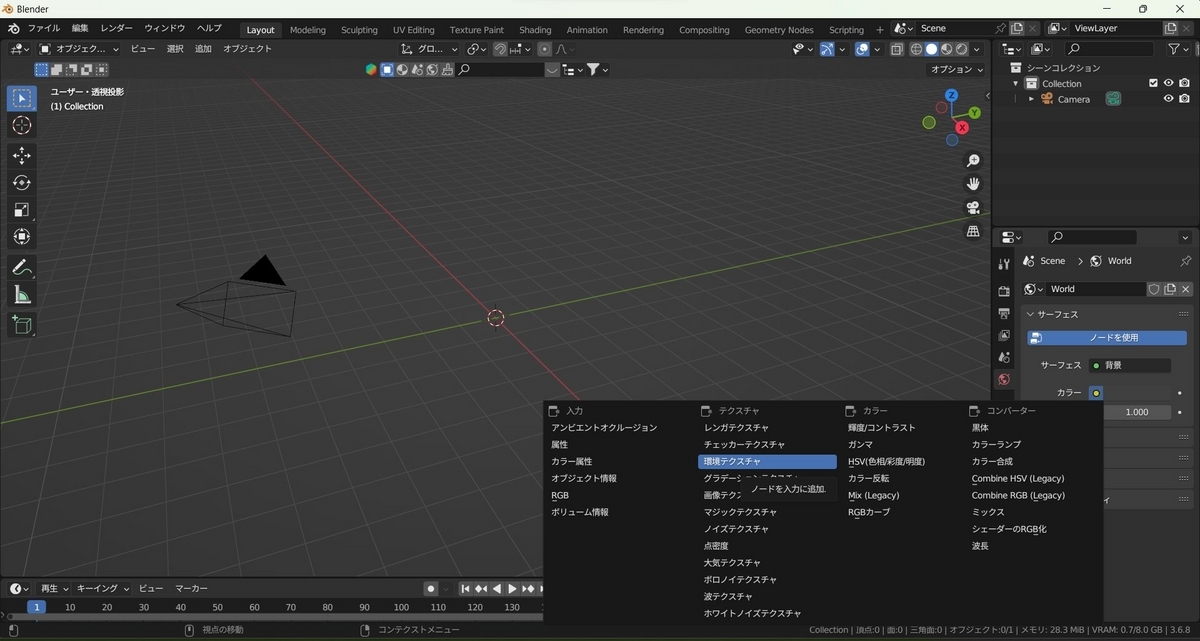

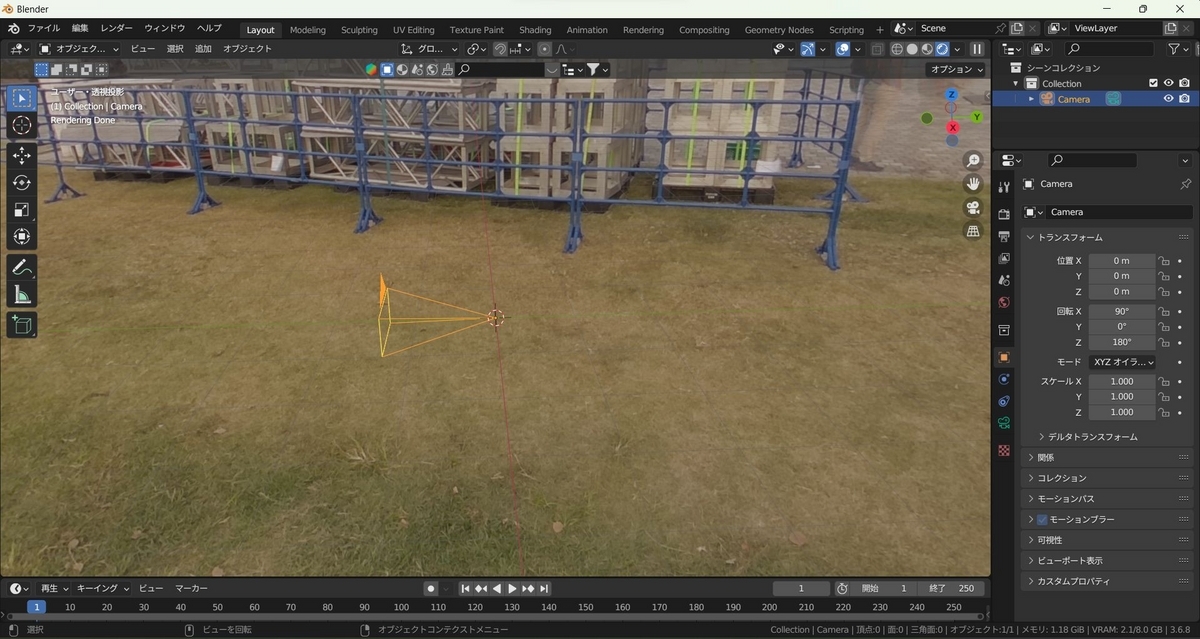

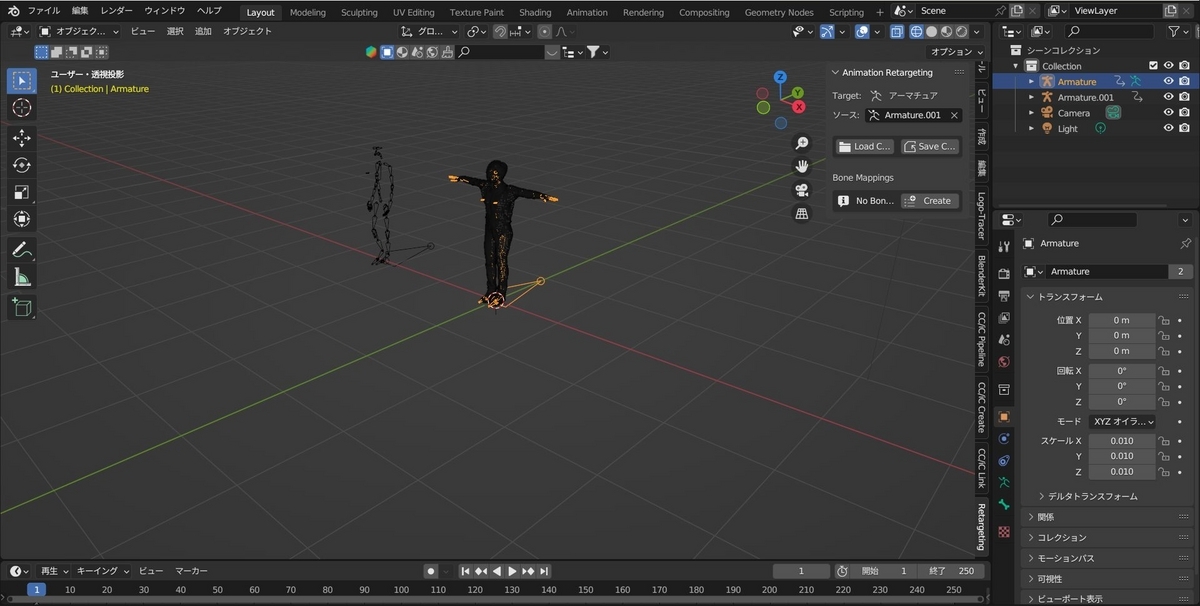

Blenderに、リグありモデルをインポートします。(先のExportボタンでダウンロードしたもの)

Blenderに、アニメーションFBXをインポートします。(先のDownload(Motion)ボタンでクラウドサービスからダウンロードしたもの)

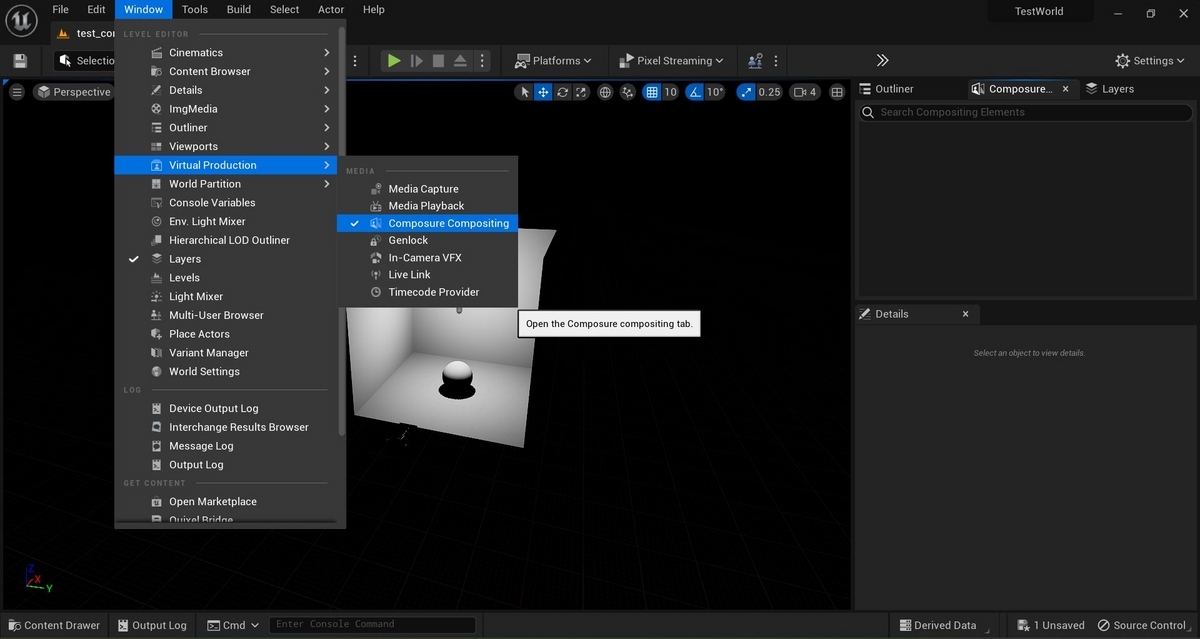

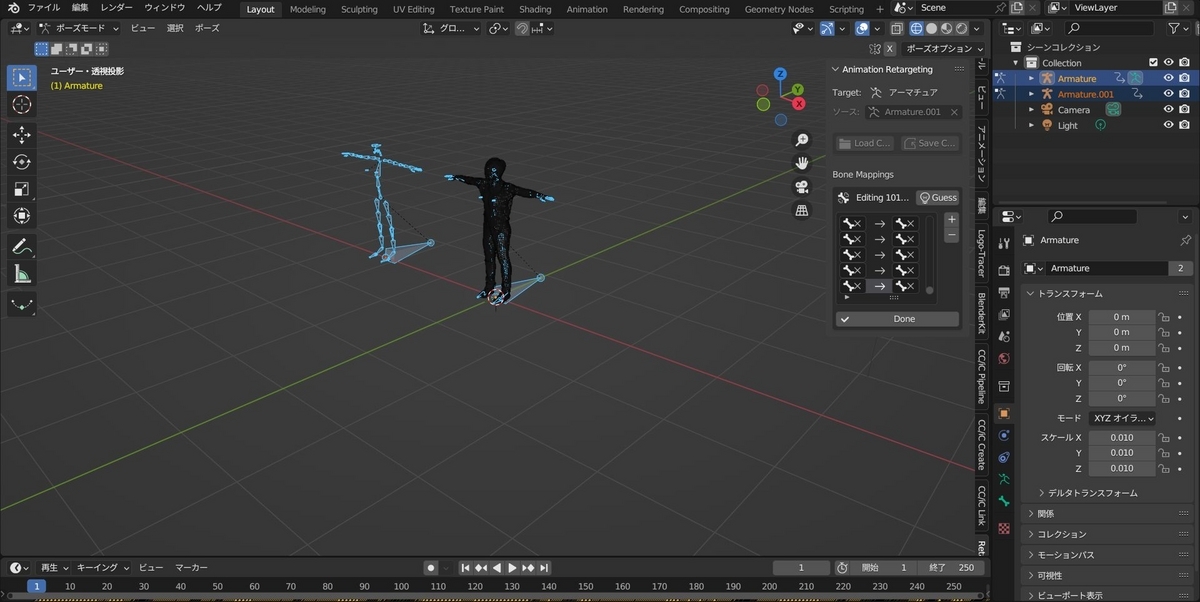

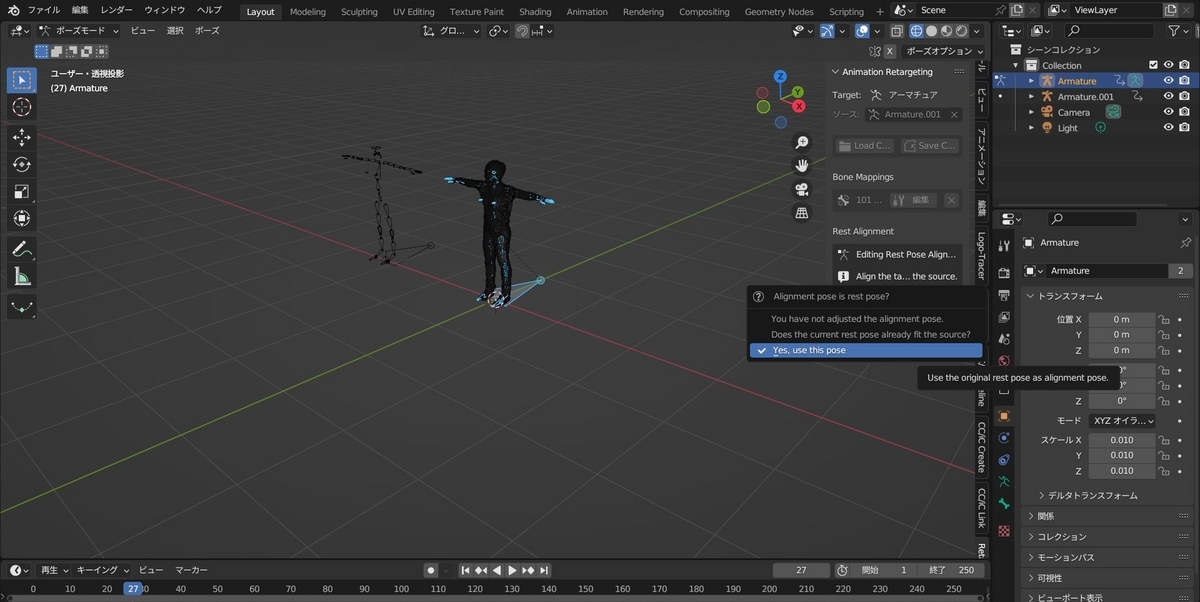

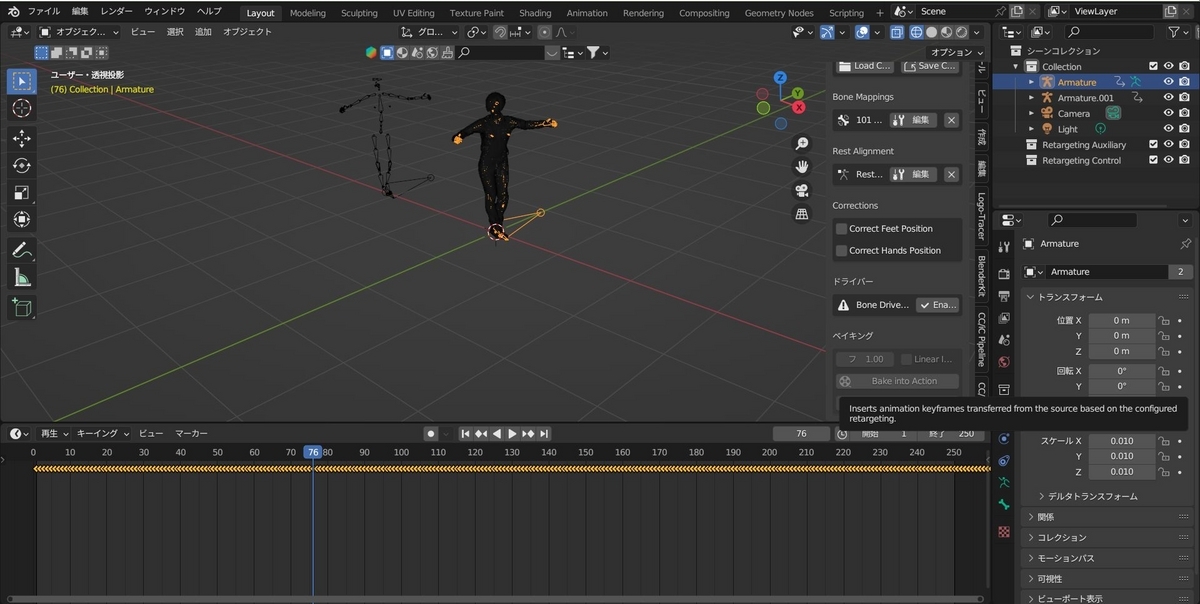

blender-animation-retargeting(https://github.com/Mwni/blender-animation-retargeting) を利用してアニメーションをリターゲットします。

blender-animation-retargetingでBake in Animationボタンをおせば、アニメーションをターゲットに転写できます。

AccuRIGだけでアニメーションも管理できればよかったのですが、アニメーションはクラウドサービスを利用しないとだめそうでした。またAccuRIGのBlenderプラグインでアニメーションの転写も試したのですが上手くいかなかったので、 blender-animation-retargeting(https://github.com/Mwni/blender-animation-retargeting) を利用してアニメーションをリターゲットしました。便利そうで便利でもないですがせっかく使ったので手順を残しました。